[ad_1]

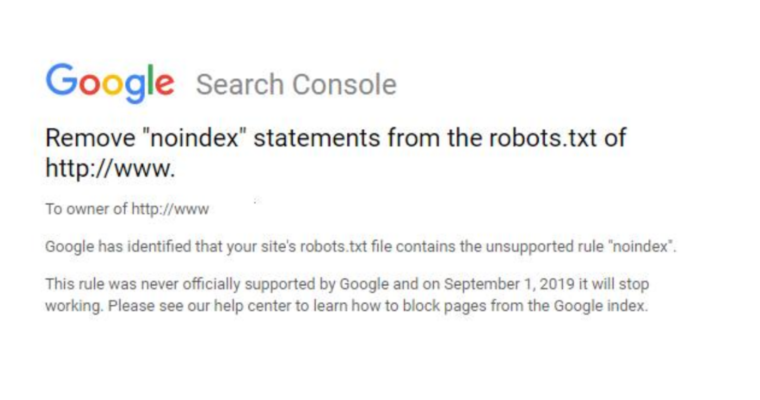

Google通过Search Console向网站管理员发送电子邮件,告知他们从robots.txt文件中删除noindex语句。

电子邮件内容为:

“Google已确定您网站的robots.txt文件包含不受支持的规则”noindex“。此规则从未得到Google的正式支持,并且在2019年9月1日它将停止工作。请访问我们的帮助中心,了解如何屏蔽Google索引中的网页。“

这些通知发布在Google之后几周 正式取消 支持noindex规则。

目前,Googlebot仍然遵守noindex指令,并将继续这样做,直到9月1日。然后,网站所有者需要使用替代方案。

从技术上讲,正如电子邮件中所述,谷歌从未有义务首先支持noindex指令。当谷歌开始被网站所有者广泛使用时,这是一个非正式的规则。

robots.txt缺乏一套标准化的规则本身就是另一个问题 – 谷歌面临的一个问题 坚定不移地努力解决。

在确定标准规则列表之前,最好不要仅仅依赖非官方规则。

以下是阻止页面编入索引的其他一些选项:

- 直接在页面的HTML代码中使用noindex元标记

- 404和410 HTTP状态代码

- 密码保护

- 在robots.txt中禁用

- 搜索控制台删除URL工具