[ad_1]

有几种类型的指令告诉搜索引擎机器人将允许哪些页面和其他内容搜索引擎机器人 抓取和索引。最常见的是robots.txt文件和元机器人标签。

该 的robots.txt 文件告诉搜索引擎抓取您网站的特定部分,无论是网页,子文件夹等。

这最终有助于通过告知您不希望优先编制索引的Google网站中较不重要的部分来产生更优化的抓取。

但请记住,搜索引擎机器人不需要尊重此文件。

另一个常用的指令是元机器人标签。这允许在页面级别进行索引控制。

元机器人标记可包含以下值:

- 索引:允许搜索引擎将页面添加到其索引中。

- Noindex:禁止搜索引擎在其索引中添加页面,并禁止它出现在该特定搜索引擎的搜索结果中。

- 关注:指示搜索引擎关注页面上的链接,以便抓取可以找到其他页面

- Nofollow:指示搜索引擎不关注页面上的链接。

- 无:这是noindex的快捷方式,nofollow。

- 全部:这是索引的快捷方式,请按照。

- Noimageindex:禁止搜索引擎对页面上的图像编制索引(但是,如果要从另一个站点链接到图像,仍然可以使用元机器人标记对图像进行索引)。

- Noarchive:告诉搜索引擎不显示页面的缓存版本。

- Nocache:这与noarchive标签相同,但特定于Bingbot / MSNbot。

- Nosnippet:指示搜索引擎不显示文本或视频片段。

- Notranslate:指示搜索引擎不在SERP中显示页面的翻译。

- Unavailable_after:告诉搜索引擎特定的日期和时间,他们不应在索引中显示结果。

- Noyaca:指示Yandex爬虫机器人不在结果中使用页面描述。

但是,还有另一个标签允许发出noindex,nofollow指令。

X-Robots-Tag与robots.txt文件和元机器人标签不同,因为X-Robots-Tag是HTTP标头的一部分,除了特定元素外,还控制整个页面的索引。在页面上。

根据 谷歌:

“任何可以在机器人元标签中使用的指令也可以指定为X-Robots-Tag。”

虽然您可以使用元机器人标记和X-Robots标记在HTTP响应的标头中设置与robots.txt相关的指令,但在某些情况下您可能希望使用x-robots标记。

例如,如果您想要阻止特定图像或视频,则可以使用HTTP响应方法。

从本质上讲,X-Robots-Tag的强大之处在于它比元机器人标签更灵活。

常用表达 也可以使用,在非HTML文件上执行爬网指令,以及在更大的全局级别上应用参数。

为了进一步解释所有这些指令之间的区别,将它们分类为它们所属的指令类型是有帮助的。这些是爬虫指令或索引器指令。

| 履带式指令 | 索引器指令 |

| Robots.txt – 使用用户代理,允许,禁止和站点地图指令来指定允许哪些搜索引擎机器人抓取并且不允许抓取的站点。 | Meta Robots标签 – 允许您指定和阻止搜索引擎在搜索结果中显示网站上的特定页面。

Nofollow – 允许您指定不应传递权限或PageRank的链接 X-Robots-tag – 允许您控制索引指定文件类型的方式 |

真实世界的例子和X-Robots-Tag的使用

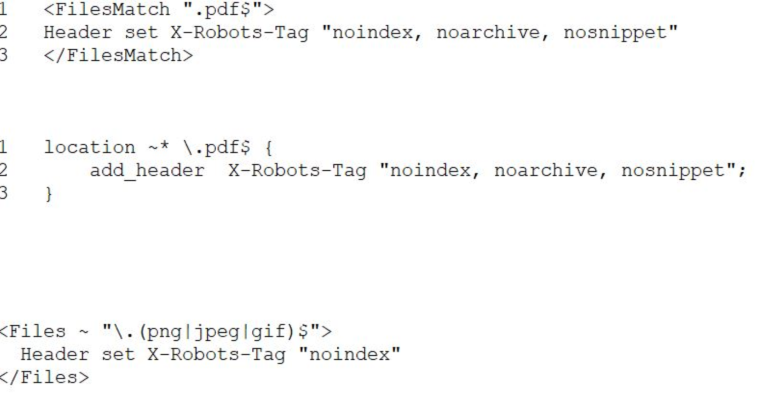

要阻止特定的文件类型,理想的方法是将X-Robots-Tag添加到Apache配置或.htaccess文件中。

可以通过.htaccess文件将X-Robots-Tag添加到Apache服务器配置中的站点HTTP响应中。

例如,假设我们希望搜索引擎不要索引.pdf文件类型。 Apache服务器上的此配置如下所示:

在Nginx中,看起来如下所示:

在不同的场景中,假设我们想要使用X-Robots-Tag来阻止图像文件的索引,例如.jpg,.gif,.png等。这样的示例如下所示:

了解这些指令的组合及其对彼此的影响至关重要。

假设当爬虫机器人发现URL时,X-Robots-Tag和Meta Robots标签都会被找到。

如果从robots.txt阻止该URL,则无法发现某些索引和服务指令,也不会遵循这些指令。

如果要遵循指令,则不能禁止包含这些指令的URL进行爬网。

检查X-Robots-Tag

可以使用几种不同的方法来检查站点上的X-Robots-Tag。

一种方法是通过Screaming Frog。

通过Screaming Frog运行站点后,您可以导航到“Directives”选项卡并查找“X-Robots-Tag”列,然后查看站点的哪些部分正在使用该标记,以及哪些特定指令。

还有一些不同的插件,例如 Web Developer插件,允许您确定是否正在使用X-Robots-Tag。

通过单击浏览器中的插件,然后导航到“查看响应标头”,您可以看到正在使用的各种HTTP标头。

总结一下

有多种方法可以指示搜索引擎机器人不抓取页面上的某些部分或某些资源。

了解每个以及它们如何相互影响对于避免任何与SEO指令相关的主要陷阱至关重要。

图片来源

特色图片及作者截图,2019年6月