[ad_1]

抓取预算的优化对于使搜索引擎抓取工具每次访问时都将注意力集中到您网站上最重要的页面上至关重要。

改善检索预算的一些主要好处包括:

- 降低服务器/带宽成本。

- 提高有价值页面的爬网率。

- 发现新页面的速度提高。

- 提高索引中已更改页面的更新速度。

Googlebot的设备齐全,可以在每次访问时在较小站点上的大部分页面中进行爬网,因此可以解释为什么像John Mueller这样的Google员工不希望网站所有者浪费时间担心会被爬网的站点。

IMO爬网预算被高估。大多数站点都无需为此担心。这是一个有趣的话题,如果您要爬网或运行数十亿个URL的网站,这一点很重要,但对于普通网站所有者而言,则不那么重要。

-?约翰(@JohnMu) 2018年5月30日

但是,抓取预算分析并不仅仅是查看Googlebot是什么,还是没有抓取什么。

更详细地分析搜索引擎机器人的行为会带来很多价值,这就是每个SEO都应将其纳入日常工作的原因。

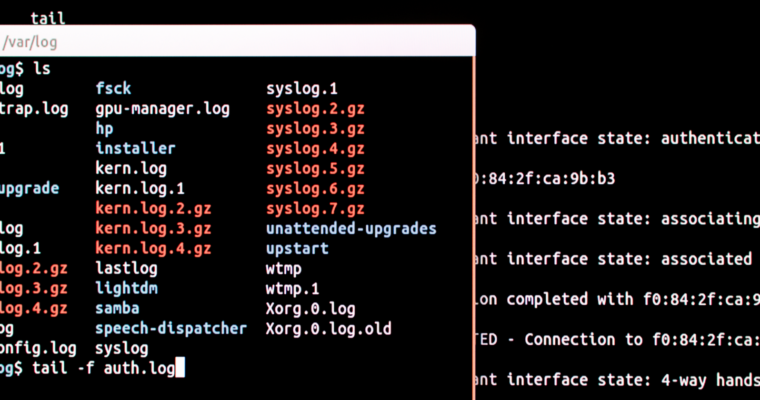

什么日志文件可以显示有关搜索引擎行为的信息

通过研究日志文件,您可以查看搜索引擎的爬网方式,而不仅仅是它们的爬网方式。

通过用日志文件数据绘制每个爬网程序的行程,您可以汇总一张有价值的图片,以显示搜索引擎认为重要的内容以及它们所遇到的困难。

以下是过滤日志文件数据以获取对搜索引擎行为最有影响力的见解的五种关键方法:

- 状态码

- 可转位性

- 内部连结

- 网站分类

- 有机表现

要自己尝试以下方法,您需要访问:

- 网站的日志文件(或类似 阳光 通过跟踪标记监控搜索引擎机器人的活动)。

- 一种爬网工具,用于集成Google Analytics(分析)和Google Search Console等工具中的数据。

- 一个好的老式电子表格,可以进行一些过滤和透视。

1.状态码

通过按状态代码对日志文件数据进行分组,您可以评估爬网预算如何在站点的不同页面上分配。

这为您提供了一个概述,概述了搜索引擎的抓取预算在重要的200个页面上花费了多少,在错误页面和重定向上浪费了多少。

动作

在这些数据的支持下,您可以采取一些步骤来改善整个网站的抓取预算:

- 分析200个状态代码URL,以识别不需要爬网的任何URL。

- 将带有200个状态代码的非必要网页的禁止规则添加到您的robots.txt文件中,以使抓取工具无法访问它们。

- 删除指向404页的内部链接,并在必要时重定向它们。

- 从XML网站地图中删除所有非200状态代码页。

- 修复重定向链,以确保搜索引擎搜寻器和用户所访问的每个重定向中只有一个步骤。

2.可转位性

有许多不同的因素会影响页面是否会被搜索引擎索引,例如meta noindex标签和规范标签。

您可以从爬网工具中获取这种数据,然后将其与日志文件数据结合起来,以分析正在爬网的页面与索引页面之间的任何差异。

重要的是要确保搜索引擎机器人不会浪费时间来爬行甚至无法添加到索引或在索引中更新的页面。

动作

收集完这些数据后,您可以按照以下步骤处理不可索引的页面并提高抓取效率:

- 检查要抓取的不可索引页面实际上不是应该允许建立索引的重要页面。

- 在robots.txt文件中添加禁止路径,以阻止低质量的不可索引网页被抓取。

- 在页面上添加相关的noindex标签和规范标签以向搜索引擎显示它们的重要性不高。

- 识别被robots.txt规则阻止的搜索引擎所抓取的不允许访问的页面。

- 确保您的Google Search Console参数设置正确且最新。

3.内部链接

内部链接在影响搜索引擎应更频繁地爬行哪些页面方面具有很大的分量。

页面具有的内部链接越多,就越容易被发现,并且每次Google访问您的网站时,其被抓取的可能性就越大。

使用内部链接数据覆盖漫游器点击数据可以使您了解有多少搜索引擎了解您的网站及其结构,以及它们如何容易地找到您网站的不同区域。

动作

您可以实施以下一些修补程序,以通过内部链接提高检索效率:

- 识别收到大量机器人点击的内部链接,并评估这些链接是否为主URL。

- 更新内部链接到规范的URL。

- 确保所有内部链接都指向200个状态代码的最终目标URL,并且没有重定向。

- 识别出受到机器人点击次数较少的重要页面,并向这些页面添加更多内部链接以提高抓取频率。

4.网站类别

并非所有网站类别都具有相同的权重和重要性,这对于企业推动转化或通过搜索引擎向其发送自然流量是至关重要的。

对于电子商务网站,产品页面将需要由搜索引擎更频繁地抓取,因为它们经常更改,并且这些更改需要不断反映在搜索引擎的索引中。

但是,就爬网频率而言,每年更新一次的常绿博客文章对于网站的优先级要低得多。

按站点类别对日志文件数据进行细分可以提供宝贵的见解,以了解每个日志文件的可爬网性以及搜索引擎对其进行访问的频率。

动作

您可以采取一些步骤来提高整个网站类别的抓取效率:

- 找出获得大量机器人点击但未获得点击或展示的细分。

- 确定受到机器人攻击次数较少的网站细分,并确保可以轻松地在网站体系结构中访问它们以改善抓取。

- 评估大量抓取预算分散在不同网站版本之间的位置,例如单独的桌面和移动页面以及AMP(加速的移动页面)。

- 映射每个细分的抓取频率,以确保Googlebot能够通过定期抓取分类来跟上经常变化的页面类别。

5.有机绩效

您可以用来覆盖日志文件数据的一些最有价值的指标是自然的性能指标,例如SERP(搜索引擎结果页)中的展示次数以及用户到您网站的访问量。

了解搜索引擎如何抓取和导航您的网站很重要,但是我们的最终目标是让用户获得我们的内容。

某个网页可能受到搜索引擎机器人的欢迎,但是由于该网页没有获得任何展示次数或点击量,因此这一点会令人沮丧。

将性能指标与日志文件数据进行映射,可以分析页面对用户的可访问性,而不仅仅是搜索引擎。

动作

您可以采取以下步骤来提高关键页面的可发现性及其在自然搜索中的性能:

- 识别正在接收流量的页面和未被搜索引擎抓取的印象。

- 确保XML站点地图中包含高性能页面,并改善与它们的内部链接,以鼓励进行更常规的爬网。

- 找出经常被抓取但未获得展示或点击量的页面,并将其过滤为主要页面。

- 用来查看哪些重要网页效果不佳的网址。

- 审核这些效果不佳的页面,以检查可能影响其排名性能的问题,例如内容质量和目标定位,以及索引和渲染问题,这些问题可能会阻止搜索引擎访问其内容。

持续的日志文件监控至关重要

以这种方式使用日志文件数据执行爬网预算审核不仅是一项一次性的任务。要真正了解搜索引擎的行为,定期监视这些区域很重要。

抓取行为会不断波动,具体取决于多种因素的组合,例如Googlebot的抓取优先级算法以及您网站上可能影响抓取的技术问题。

因此,通过持续监控指标(例如每个网站细分的平均机器人点击率和状态代码)来跟踪整个网站上抓取预算的使用方式随时间的变化至关重要。

总结一下

日志文件分析应在每位SEO专业人员的日常工作中发挥作用,因为日志文件是您最接近了解Googlebot的一种方式。

SEO工具尝试模仿搜索引擎爬网程序的行为,但是使用日志文件,您可以分析真实情况。

通过将索引与可索引性,内部链接和页面性能等重要指标交叉引用到搜索引擎bot命中中,您将能够发现需要爬网的搜索引擎对网站可访问性的更有价值的见解。

图片积分

作者截取的所有屏幕截图,2020年2月